За останні кілька місяців спільнота, що займається штучним інтелектом, була охоплена гарячими дебатами, спровокованими двома впливовими дослідженнями, опублікованими компанією Apple. Перша - " Ілюзія мислення: дебати, що потрясли світ ай&_bhlid=a540c17e5de7c2723906dabd9b8f31cdf0c5bf18" target="_blank" id="">"GSM-Symbolic" (жовтень 2024 року), а друга -" Ілюзія мислення" (жовтень 2014 року), "Ілюзія мислення" (червень 2025), поставили під сумнів передбачувані можливості міркування моделей великих мов, викликавши неоднозначну реакцію в індустрії.

Як вже було проаналізовано в нашому попередньому дослідженні на тему «Ілюзія прогресу: імітація загальної штучної інтелектуальності без її досягнення», питання штучного мислення зачіпає саму суть того, що ми вважаємо інтелектом у машинах.

Дослідники Apple провели систематичний аналіз великих моделей міркувань (Large Reasoning Models, LRM ) - моделей, які генерують детальні сліди міркувань перед тим, як дати відповідь. Результати виявилися несподіваними, а для багатьох - тривожними.

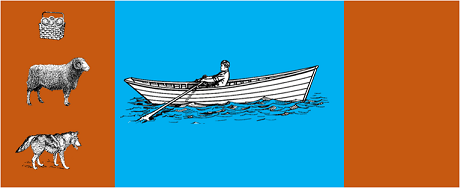

У дослідженні найдосконаліші моделі піддавалися класичним алгоритмічним головоломкам, таким як:

Результати показали, що навіть невеликі зміни у формулюванні завдань призводять до значних відмінностей у результатах, що свідчить про тривожну крихкість міркувань. Як повідомлялося в AppleInsider"продуктивність усіх моделей знижується, коли змінюються лише числові значення в тестових питаннях GSM-Symbolic".

Реакція спільноти ШІ не змусила себе довго чекати. Алекс Лоусен з Open Philanthropy у співпраці з Клодом Опусом з Anthropic опублікували детальне спростування під назвою "Ілюзія мислення".в якому оскаржуються методології та висновки дослідження Apple.

Коли Лоусен повторив тести з альтернативними методологіями, попросивши моделі генерувати рекурсивні функції замість того, щоб перераховувати всі ходи, результати кардинально змінилися. Такі моделі, як Claude, gemini та GPT, правильно розв'язали задачу "Ханойська вежа" з 15 записами, що значно перевищує рівень складності, на якому Apple повідомила про нульовий успіх.

Гері Маркусдавній критик навичок аргументації магістрів права, сприйняв результати дослідження Apple як підтвердження своєї 20-річної тези. За словами Маркуса, магістри права продовжують боротися зі "зміщенням розподілу" - здатністю узагальнювати дані, що виходять за рамки навчання, - залишаючись при цьому "хорошими вирішувачами проблем, які вже були вирішені".

Дискусія також поширилася на спеціалізовані спільноти, такі як LocalLlama на Redditде розробники та дослідники обговорюють практичні наслідки для моделей з відкритим вихідним кодом та локальної реалізації.

Ця дискусія не є суто академічною. Вона має прямі наслідки для:

Як підкреслено в декількох технічних дослідженьзростає потреба в гібридних підходах, які б поєднували в собі різні підходи:

Тривіальний приклад: АІ-помічник, який допомагає вести бухгалтерію. Мовна модель розуміє, коли ви запитуєте "скільки я витратив на подорожі цього місяця?", і витягує відповідні параметри (категорія: подорожі, період: цей місяць). Але SQL-запит, який звертається до бази даних, підраховує суму і перевіряє фіскальні обмеження? Це робить детермінований код, а не нейронна модель.

Спостерігачі не могли не помітити, що документ Apple був опублікований незадовго до WWDC, що викликало питання щодо стратегічних мотивів. Як показаваналіз 9to5Mac"вибір часу для публікації доповіді Apple - безпосередньо перед WWDC - підняв кілька брів. Чи було це важливим етапом дослідження, чи стратегічним кроком, спрямованим на репозиціонування Apple в більш широкому ландшафті ШІ?"

Дебати, викликані документами Apple, нагадують нам, що ми все ще перебуваємо на ранніх стадіях розуміння штучного інтелекту. Як зазначалося в нашій попередній статтірозрізнення між симуляцією та автентичним мисленням залишається однією з найскладніших проблем сучасності.

Справжній урок полягає не в тому, чи можуть ШІ "міркувати" в людському розумінні цього терміну, а в тому, як ми можемо побудувати системи, які використовують їхні сильні сторони, компенсуючи їхні обмеження. У світі, де штучний інтелект вже трансформує цілі галузі, питання вже не в тому, чи є ці інструменти "розумними", а в тому, як їх ефективно і відповідально використовувати.

Майбутнє корпоративного ШІ, ймовірно, буде не за одним революційним підходом, а за розумною оркестровкою декількох взаємодоповнюючих технологій. І в цьому сценарії здатність критично і чесно оцінювати можливості наших інструментів сама стає конкурентною перевагою.

Останні події (січень 2026 року)

OpenAI випускає o3 та o4-mini: 16 квітня 2025 року OpenAI випустила o3 та o4-mini, найдосконаліші моделі міркування серії o. Ці моделі тепер можуть використовувати інструменти в агентному режимі, поєднуючи веб-пошук, аналіз файлів, візуальне міркування та генерацію зображень. o3 встановив нові рекорди на таких бенчмарках, як Codeforces, SWE-bench і MMMU, а o4-mini оптимізує продуктивність і витрати для завдань міркування з великим обсягом даних. Моделі демонструють здатність «мислити зображеннями», візуально перетворюючи вміст для більш глибокого аналізу.

DeepSeek-R1 потрясает индустрию искусственного интеллекта: в январе 2025 года DeepSeek выпустила R1, модель открытого исходного кода, которая достигла производительности, сопоставимой с OpenAI o1, при стоимости обучения всего 6 миллионов долларов (по сравнению с сотнями миллионов западных моделей). DeepSeek-R1 доводить, що можливості міркування можна стимулювати за допомогою чистого підкріплювального навчання, без необхідності анотованих людських демонстрацій. Модель стала безкоштовним додатком № 1 в App Store і Google Play у десятках країн. У січні 2026 року DeepSeek опублікувала розширену 60-сторінкову статтю, в якій розкриває секрети навчання і відверто визнає, що такі техніки, як Monte Carlo Tree Search (MCTS), не працювали для загального міркування.

Anthropic оновлює «Конституцію» Клода: 22 січня 2026 року Anthropic опублікувала нову конституцію Клода, що складається з 23 000 слів, перейшовши від підходу, заснованого на правилах, до підходу, заснованого на розумінні етичних принципів. Цей документ стає першою основою великої компанії в галузі штучного інтелекту, яка офіційно визнає можливість свідомості або морального статусу штучного інтелекту, стверджуючи, що Anthropic піклується про «психологічне благополуччя, самосвідомість і добробут» Клода.

Дебати загострюються: у липні 2025 року було проведено повторне дослідження та вдосконалено тести Apple, яке підтвердило, що LRM все ще демонструють когнітивні обмеження при помірному збільшенні складності (приблизно 8 дисків у вежі Ханоя). Дослідники довели, що це залежить не тільки від обмежень виходу, але й від реальних когнітивних обмежень, підкресливши, що дебати ще далеко не завершені.

Наша команда експертів готова надати індивідуальні консультації щодо стратегії вашої організації у сфері штучного інтелекту та впровадження надійних рішень.